Alors que Google continue d’améliorer son algorithme de recherche, les pratiques de référencement doivent évoluer rapidement et de manière cohérente pour rester compétitives. Mais s’il y a un aspect du référencement qui a connu le plus grand changement sur la plus courte période de temps, c’est bien le référencement technique.

Le référencement technique est un peu un terrier de lapin, commençant par la mise en œuvre de mesures proactives pour anticiper le prévisible, pour créer frénétiquement des stratégies réactives pour réparer ce qui est cassé. Qu’il s’agisse de préparer le lancement d’un nouveau site ou d’auditer la santé actuelle d’un site, la mise en place d’une liste de contrôle SEO technique peut vous aider à rester organisé et sur la bonne voie.

Chez Boosteseo, nous ne sommes pas étrangers aux défis techniques qui accompagnent le SEO. En fait, nous sommes toujours impliqués dans un certain nombre de projets de nettoyage technique pour aider à inverser les baisses de trafic sur plusieurs sites. Les avantages du référencement technique nous ont inspirés pour partager notre liste de contrôle SEO technique en dix étapes.

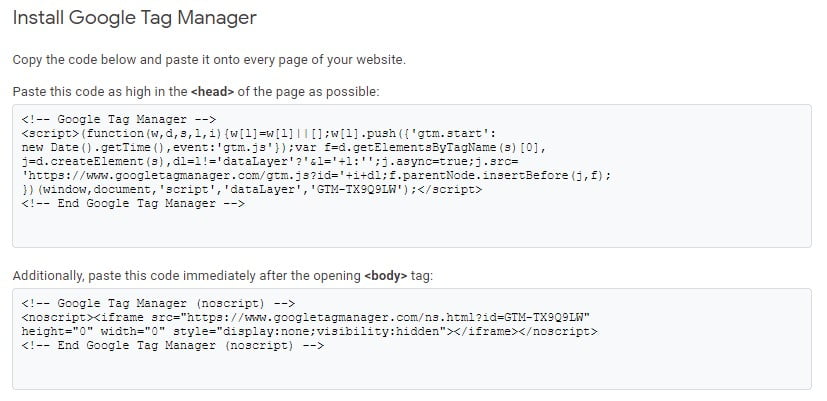

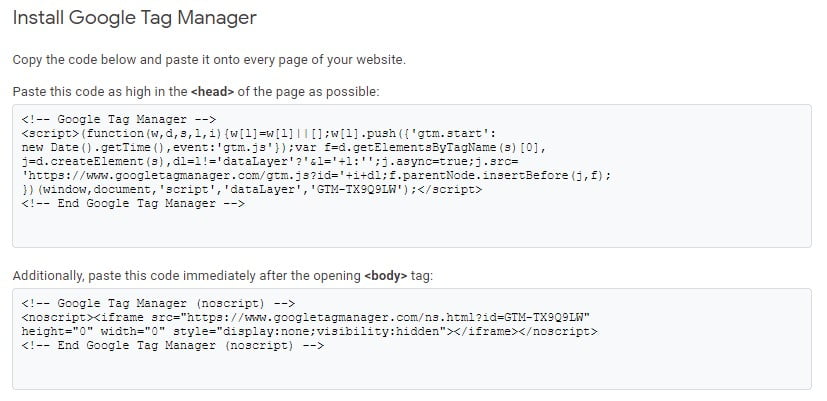

1. Validez Google Search Console, Analytics et Tag Manager

Bien que cette première étape puisse sembler évidente pour certains, il est essentiel de souligner l’importance de disposer d’outils d’analyse et de suivi fondamentaux. Pensez simplement aux blagues surutilisées comme « est-il branché? » et « essayez de l’éteindre et de le rallumer » – les éléments fondamentaux et apparemment faciles sont parfois négligés, causant des maux de tête inutiles plus tard.

Avoir des outils tels que Google Analytics, Google Search Console (anciennement Webmaster Tools) et Google Tag Manager correctement configurés et configurés est essentiel pour identifier les problèmes à mesure qu’ils surviennent. Ces outils ne peuvent pas non plus être considérés comme des implémentations de type « one-and-done ». Nous vous recommandons de consulter régulièrement les alertes et les messages générés par ces outils pour anticiper les problèmes éventuels.

2. Canonicaliser toutes les pages

S’il y a un problème que nous avons rencontré maintes et maintes fois, c’est de trouver plusieurs versions de la même page. En fait, nous avons rencontré des sites avec plus de cinq versions d’URL différentes de la même page se chevauchant. Lorsque nous voyons ce problème, cela est généralement dû à une mauvaise configuration du serveur ou à un système de gestion de contenu instable. Par exemple, un projet avait les URL suivantes générées pour sa page « À propos de nous » :

- https://site.com/about-us/

- https://www.site.com/about-us/

- https://www.site.com/about-us

- https://site.com/about-us

- http://www.site.com/about-us

Pour un moteur de recherche, ce qui précède ressemble à cinq pages distinctes, toutes avec exactement le même contenu. Cela provoque alors de la confusion, ou pire encore, fait apparaître le site comme du spam ou superficiel avec autant de contenu en double. Le correctif pour cela est la canonisation.

3. Implémenter un balisage de données structurées approprié

La mise en œuvre du balisage de données structurées est devenue la nouvelle référence en matière de pratiques de référencement technique. Dans son essence même, Schema est une forme unique de balisage qui a été développée pour aider les webmasters à mieux communiquer le contenu d’un site aux moteurs de recherche.

De l’adresse et des informations de localisation d’une entreprise aux avis et notes globales, avec les données structurées, vous pouvez définir avec précision des éléments de contenu afin que Google et les autres moteurs de recherche puissent interpréter correctement la signification du contenu. À son tour, votre site peut bénéficier des résultats de recherche avec des extraits riches, des méta-descriptions étendues et d’autres éléments accrocheurs offrant un avantage concurrentiel. Google Search Console enregistrera également toutes les erreurs détectées avec les données structurées et fournira un outil de validation pour vous aider lors de l’ajout du balisage au contenu de votre site.

Pour plus d’informations sur les différents types de schémas et de propriétés disponibles pour les données structurées, rendez-vous sur Schema.org.

4. Examinez le fichier Robots.txt

Le fichier robots.txt, également connu sous le nom de « protocole d’exclusion des robots », est un autre outil de communication pour les robots des moteurs de recherche. Ce fichier, qui est téléchargé sur un site donné, offre aux webmasters la possibilité de spécifier les zones du site Web qui ne doivent pas être traitées ou explorées. Ici, certaines URL peuvent être interdites, empêchant les moteurs de recherche de les explorer et de les indexer.

Remarque : Tous les robots d’exploration des moteurs de recherche ne sont pas créés égaux. Il y a de fortes chances que ces pages soient toujours explorées, mais il est peu probable qu’elles soient indexées. Si vous avez des URL répertoriées comme « ne pas indexer » dans le fichier robots.txt, vous pouvez être tranquille en sachant que tout ce qui se trouve dans ces URL ne sera pas considéré comme du contenu superficiel ou dupliqué lorsque le moteur de recherche prendra la mesure de votre site.

Robots.txt est un fichier mis à jour au fil du temps pour ajuster les paramètres d’exploration de certains répertoires ou contenus sur votre site Web afin que votre site puisse être autorisé ou non pour l’exploration et l’indexation. De plus, vous pouvez garantir la confidentialité de certaines pages en les rendant inaccessibles aux moteurs de recherche. Quelles que soient vos intentions, il est toujours sage d’évaluer le fichier robots.txt d’un site pour vous assurer qu’il correspond à vos objectifs de référencement et pour éviter tout conflit futur.

Vous devez également consulter le fichier robots.txt pour une référence au sitemap XML du site. Si la structure de votre sitemap est mise à jour, il est impératif que vous mettiez également à jour la référence dans le fichier robots.txt.

5. Identifiez les erreurs de crawl, les liens brisés et les métadonnées en double

À l’aide d’outils tels que Google Search Console, Raven Tools, Screaming Frog, Moz ou notre favori personnel, SEMrush, vous pouvez identifier efficacement les problèmes techniques de référencement susceptibles d’entraver les performances d’un site. Ces problèmes incluent des erreurs d’exploration, comme des liens brisés ou morts (404 pages), et des problèmes de contenu en double, y compris des titres et des descriptions Meta redondants.

Comme le résume le mieux Yoast, les erreurs d’exploration se produisent lorsqu’un moteur de recherche tente d’atteindre une page de votre site Web mais ne parvient pas à l’atteindre. Il existe un certain nombre de différents types d’erreurs d’exploration qui peuvent affecter les performances d’un site. Ainsi, si vous rencontrez des erreurs de crawl, il est important de les corriger rapidement et correctement. Nous vous recommandons de vérifier les erreurs d’exploration et les problèmes de contenu en double dans le cadre du programme de maintenance régulier de votre site.

6. Implémenter les balises Hreflang appropriées

Le référencement international présente des défis uniques pour l’intégrité technique du site. Le plus courant d’entre eux est l’ajout incorrect de déclarations hreflang sur des sites proposant plusieurs options linguistiques. La balise hreflang aide Google et d’autres moteurs de recherche à répertorier le contenu le plus approprié en fonction de l’emplacement de l’utilisateur et des paramètres de langue du navigateur.

Imaginez si vos utilisateurs américains atterrissaient continuellement sur une page écrite en allemand. Ces utilisateurs sont susceptibles de revenir immédiatement aux résultats de recherche, ce qui nuit globalement à la visibilité du site.

Voici les principaux éléments que nous recherchons lors de l’examen des balises hreflang :

- Une méthode d’implémentation cohérente : Cela peut se faire soit dans l’en-tête de chaque page, soit dans le sitemap XML. L’important ici est de choisir une méthode et de s’y tenir.

- Chaque page doit inclure des balises pour TOUTES les versions régionalisées qui existent pour cette page.

- Une valeur par défaut doit être déclarée comme solution de repli.

- Les balises hreflang ne doivent pas être utilisées en remplacement de la canonisation.

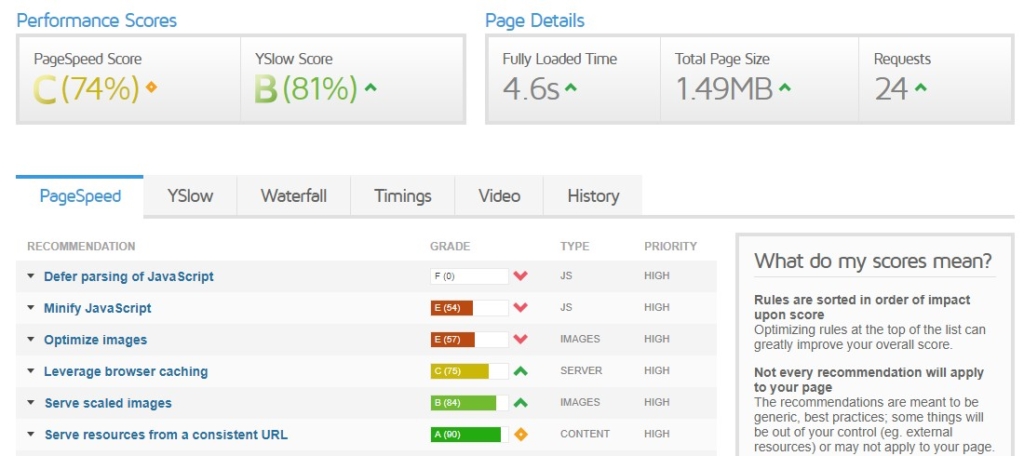

7. Évaluer les mesures de performance du site

L’un des outils les plus puissants pour l’amélioration technique de votre site Web pour le référencement est GTmetrix. Essentiellement, cet outil fournit des informations clés sur les performances de vitesse du site. À son tour, vous pouvez extraire des informations telles que la réduction de HTML, CSS et JavaScript, ainsi que l’optimisation de la mise en cache, des images et des redirections.

La vitesse du site est devenue un facteur de classement Google important au fil des ans dans le cadre de la mission de Google d’offrir aux utilisateurs la meilleure expérience possible. A ce titre, il récompense les sites à chargement rapide qui offrent une expérience utilisateur de qualité (mesurée par le taux de rebond, la moyenne des pages visitées, le temps passé sur le site, etc.)

À l’inverse, les sites maladroits qui prennent du temps à s’afficher ne réaliseront probablement pas tout leur potentiel de référencement ou de conversion. En plus de GTmetrix, il existe quelques autres outils à explorer pour tester et améliorer la vitesse et les performances de votre site. Il s’agit de Google PageSpeed Insights et Web.Dev, qui fournissent tous deux des conseils exploitables et une analyse approfondie sur un certain nombre de variables.

Les recommandations données par ces outils pour améliorer la vitesse des pages peuvent aller de la simple compression d’image à la modification de la façon dont le serveur interagit avec les requêtes. C’est une bonne idée de s’engager avec une équipe de développement bien informée si vous constatez que la majorité des recommandations se lisent comme du charabia pour vous.

8. Vérifiez les codes d’état HTTPS

Une étude sur les facteurs de classement menée par SEMrush a révélé que le HTTPS est un facteur de classement très puissant qui peut avoir un impact direct sur le classement de votre site, c’est pourquoi le passage au HTTPS est indispensable.

Cependant, lors de la migration vers HTTPS, vous devez définir des redirections appropriées, car les moteurs de recherche et les utilisateurs n’auront pas accès à votre site si vous avez toujours des URL HTTP en place. Dans la plupart des cas, ils verront les codes d’état HTTP 4xx et 5xx au lieu de votre contenu.

Aleyda Solis a dressé une liste de contrôle détaillée sur la façon de rendre la transition HTTPS plus transparente. Mais après avoir consulté sa liste, vous devez investir du temps pour évaluer toute erreur de code de statut supplémentaire.

L’utilisation d’outils tels que Screaming Frog pour générer un rapport d’exploration de site peut vous fournir toutes les erreurs d’URL, y compris les erreurs 404. Vous pouvez également utiliser Google Search Console pour obtenir cette liste, qui comprend une ventilation détaillée des erreurs potentielles. Enfin, vérifiez de temps en temps auprès de Google Search Console pour vous assurer que la liste d’erreurs de votre site est toujours vide et que vous corrigez les erreurs dès qu’elles surviennent.

9. Recherche Google « Site:VotreSite.xyz »

L’un des conseils techniques de référencement les plus simples à la disposition de tous consiste à effectuer une recherche « site : » de votre domaine directement dans le champ de recherche de Google. C’est un moyen simple de voir comment Google explore et indexe votre site.

Quelques considérations lors de la réalisation d’une recherche « site : » Google :

- Si votre site n’est pas en tête des résultats, ou totalement inexistant, soit vous avez une action manuelle de Google, soit vous bloquez accidentellement l’indexation de votre site, probablement via robots.txt.

- Si vous constatez que des métadonnées redondantes et plusieurs URL sont indexées, vous avez probablement un problème de contenu en double et devez empêcher l’indexation des URL indésirables.

- Si vos méta titres et descriptions sont tronquées (…), pensez à les modifier pour être plus concis.

Dans la figure ci-dessus, vous pouvez voir que Google explore diverses extensions uniques de la même URL (/courses/), la même méta-description étant dupliquée pour chacune. Dans ce cas, nous interdirons probablement toutes les URL « /courses/ » car elles n’offrent pas beaucoup de valeur et diluent le référencement du site.

10. Assurez la réactivité (mobile-friendly)

En bref, les sites qui ne sont pas adaptés aux mobiles souffriront dans les résultats de recherche. En utilisant des outils tels que Google Mobile-friendly Test, vous pouvez voir à quel point votre site est réactif sur les appareils mobiles. Ces outils peuvent également révéler des informations techniques plus détaillées qui sont précieuses et exploitables pour optimiser les performances de votre site.

Le mobile étant désormais la plate-forme dominante de navigation sur le Web, disposer d’un site réactif est absolument vital, non seulement pour le référencement, mais également pour les utilisateurs. Si votre site Web n’est toujours pas adapté aux mobiles, c’est le moment de donner la priorité à une refonte réactive.

Les conseils ci-dessus ne constituent certainement pas une liste exhaustive de tous les éléments techniques à prendre en compte pour votre site, mais nous espérons que cela vous donnera une longueur d’avance sur les éléments à vérifier régulièrement pour que votre site fonctionne au mieux. Quels éléments ajouteriez-vous ? Faites le nous savoir @CaptivateSearch.